È possibile un’Intelligenza Artificiale etica?

Salvare o meno la coccinella? Questo è il dilemma

Nella stessa stanza ci sono un’innocua coccinella rossa e un super-tecnologico Roomba, il robot aspirapolvere che sta rivoluzionando il mondo delle pulizie domestiche. Da una parte, un essere vivente che, seppur piccolo, rimane pur sempre un essere vivente (perdipiù con un ruolo nell’ecosistema molto più importante di quanto uno possa immaginare). Dall’altra, una macchina autonoma che si fa strada tra i gatti di polvere con la missione di pulire l’intera casa prima che rientrino i suoi occupanti “umani”. Roomba è dotato di numerosi sensori di bordo che rilevano sia i pericoli (le scale, ad esempio) che i corpi estranei sul pavimento (sporcizia e oggetti vari), agendo grazie ad una particolare tecnologia in grado di definire la logica di spostamento per la pulizia della stanza.

E qui sorge il grande dilemma: se Roomba trovasse sul suo percorso una coccinella, come dovrebbe comportarsi? Proseguire sul proprio cammino e procedere con la pulizia, incurante della povera coccinella, oppure aggirare l’ostacolo permettendole di scampare a morte certa? Si trattasse di un ragno magari non ci dispiacerebbe la prima opzione, ma parliamo di una bella coccinella rossa, che peraltro porta pure fortuna! Di fronte a questa situazione, anche Roomba dovrebbe prendere delle decisioni basate su principi morali ed etici. E quindi?

Quello di Roomba e la coccinella è un esempio forse un po’ banale, ma che introduce in maniera semplice alle questioni etiche (ben più importanti e tutt’altro che semplici!) legate alla tecnologia, che da un po’ di tempo ci mettono alla prova e che derivano dai tre mega trend rivoluzionari che stiamo vivendo oggi. Uno di questi è l’Intelligenza Artificiale, in queste sede intesa come la tecnologia che permette di interpretare i dati (strutturati e non) su grande scala, in modo automatico, la quale gioca oggi un ruolo sempre più rilevante nella nostra società ed economia.

Uomo vs. Algoritmo

Non risale a troppo tempo fa la notizia della sfida lanciata dalla società americana LawGeex, la quale ha contrapposto un algoritmo basato sull’Intelligenza Artificiale ad una schiera di venti avvocati con esperienza decennale in diritto societario. Per i partecipanti alla sfida, l’obiettivo era individuare nel minor tempo possibile e con un sufficiente livello di accuratezza, le falle presenti in cinque contratti legali. Il risultato? Gli avvocati hanno impiegato in media 92 minuti per individuare norme potenzialmente invalidanti, raggiungendo un tasso di accuratezza del 85%. Per l’algoritmo, la vittoria è stata schiacciante: in soli 26 secondi ha individuato le falle con un tasso di accuratezza del 94%.

Si raccoglie ciò che si semina

Per restare in tema, comunque, dei precedenti ci sono. Era già accaduto con gli scacchi e con il poker: l’Intelligenza Artificiale è uscita più volte trionfante da una partita contro l’intelligenza umana. Tuttavia, scacchi e poker sono entrambi ambiti dove ci sono regole facili da formalizzare e “insegnare” ad una macchina. Al contrario, il risultato della notizia riportata qui sopra – impensabile fino due anni fa – è davvero sorprendente perché l’interpretazione della legge non è poi così semplice da sistematizzare! La vera notizia, quindi, non è tanto quella che vede un algoritmo battere sul tempo e sul tasso di accuratezza l’uomo, quanto quella implicita che sottolinea l’enorme passo avanti nell’ambito dell’automatizzazione dei processi di analisi e interpretazione dei dati non strutturati (i quali, piccolo reminder, si differenziano dai dati strutturati in quanto non facili da elaborare perché conservati senza alcuno schema).

Resta però un importante quesito irrisolto. Quando l’IA si addentra in ambiti così tipicamente umani, è naturale che venga a galla una questione morale:

può una macchina prendere delle decisioni etiche? Se sì, in base a che cosa? Chi definisce cosa è etico e cosa invece non lo è per la macchina?

La verità è che i sistemi di Intelligenza Artificiale non sono – e non possono essere – neutrali: una decisione presa da un sistema di IA riflette la modalità in cui tale sistema è stato programmato o addestrato da chi l’ha creato. In altre parole, riflette il sistema di valori, aspetti culturali, ed opinioni di chi lo progetta, implementa e configura.

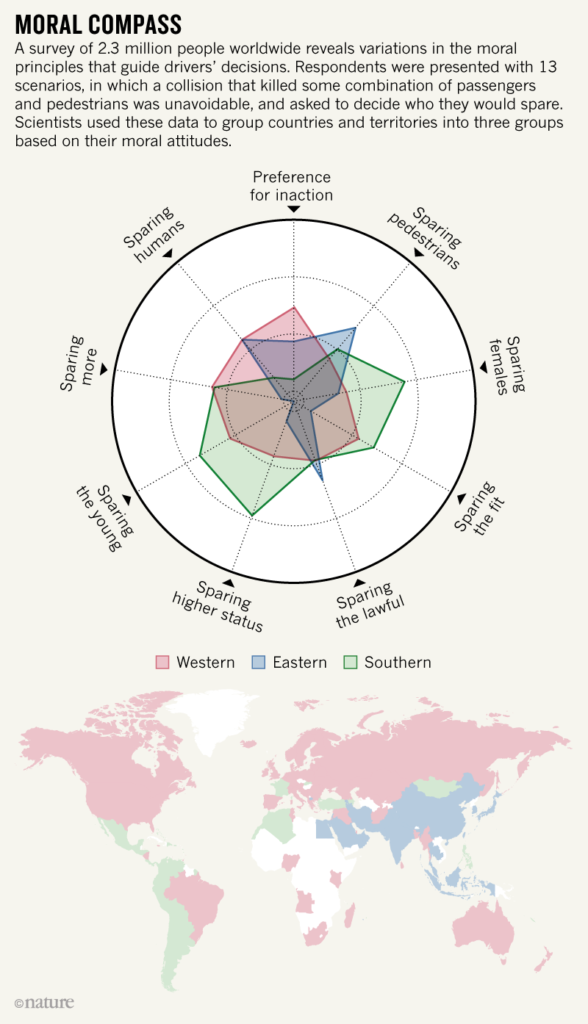

Un significativo contributo a questi studi deriva dal famoso esperimento Moral Machine, in cui un gruppo di ricercatori sottopose milioni di persone provenienti da tutto il mondo ad una questione di tipo etico: cosa dovrebbe fare un veicolo a guida autonoma con a bordo dei passeggeri in una situazione in cui ogni decisione porta comunque alla perdita di vite umane? Investo la vecchietta e il runner oppure la mamma con il bambino? Il businessman ed un anziano oppure un ladro, un cane e una giovane coppia? L’esperimento portò alla luce proprio il fatto che la decisione presa dai singoli individui riflette il sistema di valori di una cultura.

Ad esempio in molte culture orientali il ruolo degli anziani nella struttura sociale è sentito come molto più importante di quanto succeda da noi in occidente, e quindi questi venivano – negli esperimenti – “salvati” più spesso. Nell’America Centrale, America del Sud e in paesi ex colonie francesi invece si tendeva a salvare molto più spesso le donne. Questo fa dunque sorgere spontanea una domanda: codificare gli algoritmi di guida con regole etiche diverse a seconda dei diversi mercati geografici, oppure applicare uno standard universale, che sia un compromesso di tutte le diversità riscontrate tra le diverse culture?

Se l’uomo che ha progettato Roomba, avesse addestrato il robot a riconoscere gli insetti e l’avesse addestrato a girarci attorno nel caso li trovasse sul pavimento, ecco che la storia della povera coccinella potrebbe concludersi con un lieto fine.

La ricetta sbagliata

Esiste tuttavia un ulteriore ostacolo che non rende i sistemi di IA neutrali, il data bias. Come detto sopra, i sistemi di IA vengono programmati e addestrati dall’uomo; tale fase di “apprendimento” spesso si basa sul concetto di esporre l’IA ad una serie di dati. Immaginiamo, per esempio, di dover insegnare ad una IA a riconoscere i gatti. Mostreremo quindi una serie di foto di gatti, dicendo “Questo è un gatto” e una serie di foto con altri soggetti, dicendo “Questo NON è un gatto”. Con i gatti funziona tutto bene, ma in altri casi meno, in quanto se i dati su cui alleniamo una IA sono “di parte”, beh, anche l’IA diventerà “di parte”.

Facciamo un esempio. Negli Stati Uniti viene comunemente utilizzato in ambito giudiziario un algoritmo per la valutazione del rischio criminale, o indice di recidiva, ovvero la probabilità che un certo individuo giudicato colpevole possa commettere altri crimini. Questo è utilizzato ad esempio come strumento di supporto ai giudici sulle decisioni di mettere in libertà su cauzione. L’algoritmo si basa su una serie di parametri riferiti sia all’individuo che al crimine commesso, ed utilizza i dati storici del sistema giudiziario americano per stimare la probabilità di recidiva. Il problema è che i dati storici riportano una probabilità di recidiva maggiore per individui afroamericani (per tutta una serie di ragioni storiche che non approfondiamo qui). E quindi individui afroamericani – oggi! – otterranno con maggior difficoltà la libertà su cauzione. È una cosa giusta o accettabile?

Questo accade in quanto, in fin dei conti, un algoritmo è un insieme di istruzioni che descrivono come eseguire un determinato compito. Dovremmo quindi incolpare noi stessi, perché l’algoritmo sta solo eseguendo dei comandi basati sulle regole e dati che gli forniamo. Anche una ricetta per la torta di mele è un algoritmo, solo che è scritta a parole invece che in codice. E per completare la similitudine, è come se indicassimo ad un amico la ricetta con le dosi sbagliate, facendo fallire il suo tentativo di pasticceria.

E quindi?

E quindi, alla luce di tutto ciò, come si possono progettare in maniera “etica” sistemi di Intelligenza Artificiale? Sicuramente, occorre tenere conto dell’enorme livello di complessità dovuto al fatto che moralità ed etica sono dipendenti dai contesti sociali e culturali in cui le decisioni vengono prese; la diversità gioca un ruolo critico in questo ambito.

Oggi l’impegno verso una progettazione etica è in crescente aumento. Un esempio tra tutti, il progetto europeo WeNet, al quale U-Hopper sta lavorando, che aspira a progettare una piattaforma di IA capace di gestire le interazioni tra utenti appartenenti a diverse culture, evitando eventuali insidie di bias e di discriminazione statistica.

Il motivo di tale impegno è semplice: nell’avanzare verso un futuro sempre più tecnologico, non possiamo dimenticarci di tenere ben presente il fatto che il modo in cui noi progettiamo gli algoritmi ci mette in una posizione di grande potere, ma anche di grande responsabilità, in una misura mai sperimentata in passato.

Scrivici a info@u-hopper.com per ulteriori informazioni sul progetto!

Ti è piaciuto questo articolo?

Inserisci il tuo indirizzo e-mail per ricevere la nostra newsletter!

PS: odiamo lo spam proprio come te, quindi ti promettiamo solo un paio di newsletter all’anno con una raccolta degli articoli più interessanti!